Nöral kodlama ile beyin sinyallerinden sentetik konuşma geliştirildi

UC San Francisco Üniversitesinden bir nörolog tarafından geliştirilen yeni bir teknoloji ile bilgisayar ve beyin iletişiminde yeni bir çağın kapıları aralanıyor. Bir beyin-makine arayüzü geliştiren bilim insanları, beyin aktivitesini kullanarak sanal ses yaratmayı başardılar. Araştırma, konuşma problemi yaşamayan kişilerle yürütüldü, ancak bu teknoloji bir gün felç ve diğer nörolojik hasar biçimleri nedeniyle konuşma kabiliyetini yitirmiş insanların beyinleri ile yenden konuşmalarını sağlayabilir.

UC San Francisco Üniversitesinden bir nörolog tarafından geliştirilen yeni bir teknoloji ile bilgisayar ve beyin iletişiminde yeni bir çağın kapıları aralanıyor. Bir beyin-makine arayüzü geliştiren bilim insanları, beyin aktivitesini kullanarak sanal ses yaratmayı başardılar. Araştırma, konuşma problemi yaşamayan kişilerle yürütüldü, ancak bu teknoloji bir gün felç ve diğer nörolojik hasar biçimleri nedeniyle konuşma kabiliyetini yitirmiş insanların beyinleri ile yenden konuşmalarını sağlayabilir.

İnme, travmatik beyin hasarı ve parkinson hastalığı, multipl skleroz ve amyotrofik lateral skleroz (ALS veya Lou Gehrig hastalığı) gibi nörodejeneratif hastalıklar genellikle konuşma kabiliyetinin geri dönüşümsüz bir şekilde kaybedilmesine neden olabiliyor. Ağır konuşma kaybı olan bazı hastalar, göz veya yüz kas hareketlerini izleyen yardımcı cihazları kullanarak düşüncelerini harf harf hecelemeyi öğreniyor.

Bu sistemler bir hastanın yaşam kalitesini arttırsa da bu tür cihazlarla metin üretmek veya sanal konuşma yapmak zahmetli, hataya açık ve kişiye acı verici bir şekilde yavaştır. Çoğu kullanıcı dakikada 10 kelimeden fazla konuşmakta zorlanmaktadır, doğal konuşmada dakikada ortalama 150 kelime konuşulduğunu düşünürsek bu oran oldukça düşük kalıyor.

Edward Chang, on yıldan fazla bir süredir beynin konuşmayı nasıl ürettiğini inceliyor ve felç ve diğer nörolojik hasar nedenleri ile konuşma yetisini kaybeden kişilerin sesini geri kazandırmak için bir konuşma protezi geliştirmeyi amaçlıyor. Nisan 2019’da Nature dergisinde yayınlanan, Edward Chang laboratuvarında geliştirilen yeni sistem, beyninin konuşma merkezlerinin faaliyetleriyle kontrol edilebilen ve bir kişinin sesi ile sentetik bir konuşma versiyonu yaratmanın mümkün olduğunu gösteriyor.

Edward Chang, on yıldan fazla bir süredir beynin konuşmayı nasıl ürettiğini inceliyor ve felç ve diğer nörolojik hasar nedenleri ile konuşma yetisini kaybeden kişilerin sesini geri kazandırmak için bir konuşma protezi geliştirmeyi amaçlıyor. Nisan 2019’da Nature dergisinde yayınlanan, Edward Chang laboratuvarında geliştirilen yeni sistem, beyninin konuşma merkezlerinin faaliyetleriyle kontrol edilebilen ve bir kişinin sesi ile sentetik bir konuşma versiyonu yaratmanın mümkün olduğunu gösteriyor.

Araştırmacılar bu yaklaşımın gelecekte yalnızca konuşma becerisinin kazandırılması değil, aynı zamanda konuşmacının duygularını ve kişiliğini ileten insan sesinin müzikalitesinin de kazandırılabileceğini düşünüyor.

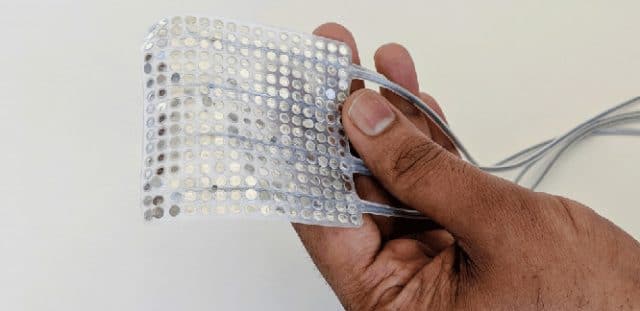

Araştırma, bir konuşma bilimcisi olan Dr. Gopala Anumanchipalli ve Chang laboratuarında biyomühendislik yüksek lisans öğrencisi Josh Chartier tarafından yürütüldü. UCSF Epilepsi Merkezinde tedavi gören, konuşma yetisini kaybetmemiş beş gönüllünün beynine geçici olarak elektrotlar yerleştirildi, ve sesli biçimde kitap okurken ve konuşurken beyin aktiviteleri kaydedildi. Katılımcıların ses kayıtlarına dayanarak araştırmacılar, dilbilim ilkelerini kullanarak şu seslerin anatomisini çıkarttılar; dudakları birbirine bastırmak, ses tellerini daraltmak, dilin ucunu damağa değdirmek, vb.

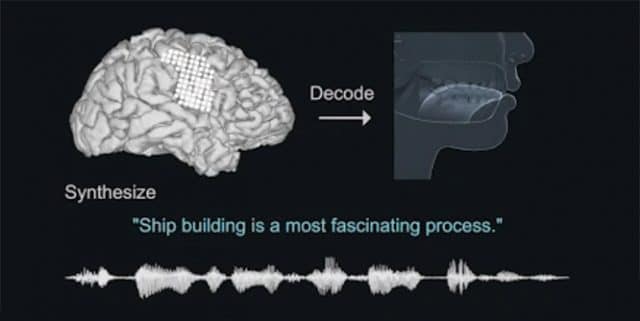

Seslerin ayrıntılı anatomisi sayesinde, bilim adamları her katılımcı için beyin aktiviteleri tarafından kontrol edilebilecek gerçekçi bir sanal ses yolu yarattılar. Bu “sinir ağı” makinesi iki algoritmadan oluşturulmuştu; konuşma sırasında üretilen beyin aktivitesini ses kanalının hareketlerine dönüştüren bir şifre çözücü ve bu ses yolu hareketlerini katılımcının sentetik sesine dönüştüren bir sentezleyici.

Araştırmacılar bu algoritmadan üretilen sentetik konuşmanın, ses yolları simülasyonu olmadan direkt katılımcının beyin aktivitelerinden üretilen konuşmadan daha iyi olduğunu tespit ettiler. Algoritma, Amazon Mechanical Turk platformunda yapılan transkripsiyon testlerinde yüzlerce dinleyicinin anlayabildiği cümleler üretti. Sentetik konuşmadaki kelimelerin %69’u, cümlelerin ise %43’ü mükemmel bir doğrulukla anlaşıldı.

Yapay Zeka, Dilbilim ve Nöroloji

Araştırmacılar, sentezlenmiş konuşmayı daha da iyileştireceğini umdukları yüksek yoğunluklu elektrot dizileri ve daha gelişmiş algoritmalar ile denemeler yapıyorlar. Bu teknolojinin bir sonraki aşaması, konuşma yetisini kaybetmiş kişinin, kendi sesiyle eğitim vermeden algoritmayı kullanmayı öğrenerek söylemek istediklerini söyleyebilmesi olacak.

Araştırma ekibinin ön sonuçlarına göre araştırmacıların anatomik tabanlı sistemini, algoritmanın üzerinde çalıştığı cümlelerin yanı sıra, katılımcıların beyin faaliyetlerinden yeni cümleleri deşifre edip sentezleyebileceğini öne sürüyor. Sadece bir katılımcı ses olmadan, cümleleri sadece ağız hareketleri ile okuduğunda da beyin aktivitesi kaydedilmiş ve sistem sessiz okunmuş cümlelerin anlaşılır sentetik versiyonlarını üretebildi.

Bu çalışma ile vokal hareketleri için nöral kodun katılımcılar arasında kısmen örtüştüğünü ve bir ses yolu simülasyonunun başka bir katılımcının beyninden kaydedilen sinirsel talimatlara cevap verecek şekilde uyarlanabileceğini buldular. Tüm bulgular nörolojik bozulma nedeniyle konuşma kaybı olan bireylerin, konuşma yetisini kaybetmemiş bir kişinin sesine göre modellenen bir konuşma protezini kontrol etmeyi öğrenebileceklerini göstermektedir. Kaynak:

Journal Reference: Gopala K. Anumanchipalli, Josh Chartier, Edward F. Chang. Speech synthesis from neural decoding of spoken sentences. Nature, 2019; 568 (7753): 493 DOI: 1038/s41586-019-1119-1

YAZIYI PAYLAŞ

UC San Francisco Üniversitesinden bir nörolog tarafından geliştirilen yeni bir teknoloji ile bilgisayar ve beyin iletişiminde yeni bir çağın kapıları aralanıyor. Bir beyin-makine arayüzü geliştiren bilim insanları, beyin aktivitesini kullanarak sanal ses yaratmayı başardılar. Araştırma, konuşma problemi yaşamayan kişilerle yürütüldü, ancak bu teknoloji bir gün felç ve diğer nörolojik hasar biçimleri nedeniyle konuşma kabiliyetini yitirmiş insanların beyinleri ile yenden konuşmalarını sağlayabilir.

UC San Francisco Üniversitesinden bir nörolog tarafından geliştirilen yeni bir teknoloji ile bilgisayar ve beyin iletişiminde yeni bir çağın kapıları aralanıyor. Bir beyin-makine arayüzü geliştiren bilim insanları, beyin aktivitesini kullanarak sanal ses yaratmayı başardılar. Araştırma, konuşma problemi yaşamayan kişilerle yürütüldü, ancak bu teknoloji bir gün felç ve diğer nörolojik hasar biçimleri nedeniyle konuşma kabiliyetini yitirmiş insanların beyinleri ile yenden konuşmalarını sağlayabilir. Reflüden kansere ses kısıklığına yol açan 7 önemli sorun ve hastalık

Reflüden kansere ses kısıklığına yol açan 7 önemli sorun ve hastalık Kekemelik sonrasında ortaya çıkan konuşma bozuklukları kronikleşebilir

Kekemelik sonrasında ortaya çıkan konuşma bozuklukları kronikleşebilir Ses kısıklığı nedenleri ve tedavisi

Ses kısıklığı nedenleri ve tedavisi Şiddetli baş ağrısı beyin tümörünün habercisi olabilir

Şiddetli baş ağrısı beyin tümörünün habercisi olabilir Beyin kanaması nedir? Neden olur? Belirtileri ve tedavisi

Beyin kanaması nedir? Neden olur? Belirtileri ve tedavisi

YORUMUNUZ VAR MI?